Após adesão das Big Techs à ultradireita, surge uma saída: redes federadas como Mastodom ou Bluesky, onde usuários do mundo todo usam a mesma plataforma, mas as regras de moderação são definidas por comunidades autônomas

Como chegamos aqui? O sistema centralizado de moderação de conteúdo, que começou a se fragmentar, foi moldado por uma combinação de valores políticos norte-americanos, normas sociais e realidades econômicas, como argumentou a pesquisadora e professora Kate Klonick na Revista de Direito de Harvard, em 2018.

O ensaio de Klonick, The New Governors, detalha como as políticas de governança das plataformas foram amplamente elaboradas por advogados dos EUA, cuja formação estava voltada para a Primeira Emenda à Constituição do país [– a que protege a “liberdade de expressão”].

Essas plataformas eram de propriedade privada e operadas por empresas, mas sua governança seguia o espírito da legislação norte-americana. No entanto, a maioria delas também considerava seu dever moderar conteúdos “obscenos, violentos ou de ódio”.

Isso se devia, em parte, ao desejo de serem vistas como ligadas a “boas práticas corporativas”, mas também era uma questão puramente pragmática: “A viabilidade econômica depende de atender às normas de discurso e comunidade dos usuários”, escreveu Klonick. Quando as plataformas criavam ambientes que atendiam às expectativas dos usuários, estes passavam mais tempo no site, e a receita poderia aumentar. Economia simples.

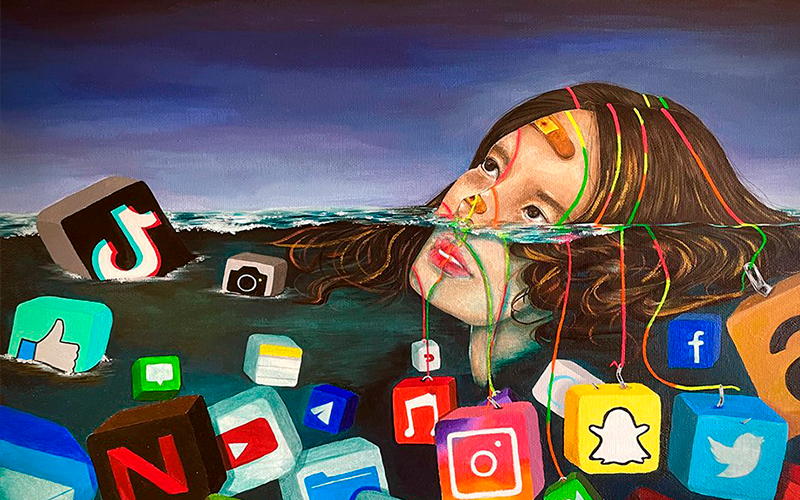

No entanto, enquanto as plataformas buscavam equilibrar responsabilidade corporativa, segurança dos usuários e viabilidade econômica, as regras tornaram-se cada vez mais pontos de conflito. As decisões de moderação de conteúdo passaram a ser vistas não como governança neutra, mas como julgamentos carregados de valores — declarações implícitas sobre quais vozes eram bem-vindas e quais não eram.

A remoção pelo Facebook da icônica foto Garota do Napal, em 2016 — devido à aplicação automatizada de regras contra nudez — provocou uma reação global, forçando a plataforma a reverter sua decisão e reconhecer as complexidades da moderação em larga escala.

Na mesma época, o Twitter enfrentou críticas por não responder adequadamente ao crescimento de propagandistas do Estado Islâmico e a campanhas de assédio como o Gamergate (um movimento online de 2014, supostamente sobre ética no jornalismo de games, mas amplamente visto como uma campanha de trolls contra mulheres do setor).

Fonte: Site OUTRAS PALAVRAS

Matéria Completa: Acesse Aqui